はじめに

今回は、Proxmox VE で既存クラスタに新規ノードを追加し、そのノードを Ceph クラスタにも参加させる手順を解説します。

本記事では、以下を前提としています:

・既に Proxmox VE (PVE) クラスタが構築済みであり、PVE クラスタ内で Ceph ストレージが運用中

・追加する新規ノードに Proxmox VE がインストール済み

・PVE のバージョンは既存ノードと合わせる(今回はバージョン8.2.2を利用します。)

- 事前準備

1-1. ノードのハードウェア・ネットワーク要件

ハードウェア:

PVE の動作に十分な CPU / メモリ / ストレージを確保してください。

今回は8コア/16GBメモリ/32GB SSD(PVEインストール)+100GB SSD(CephOSD)で構築します。

ネットワーク:

クラスタ内のノード間で通信できるネットワークインターフェース。

Ceph 用に専用ネットワークインターフェースを用意するのが理想(性能向上のため)。

※今回は検証用途なのでCephも共用として1本で構成します。

1-2. PVE インストール直後の基本設定

新規ノードに Proxmox VE をインストールしたら、まずは下記項目を確認・設定します。

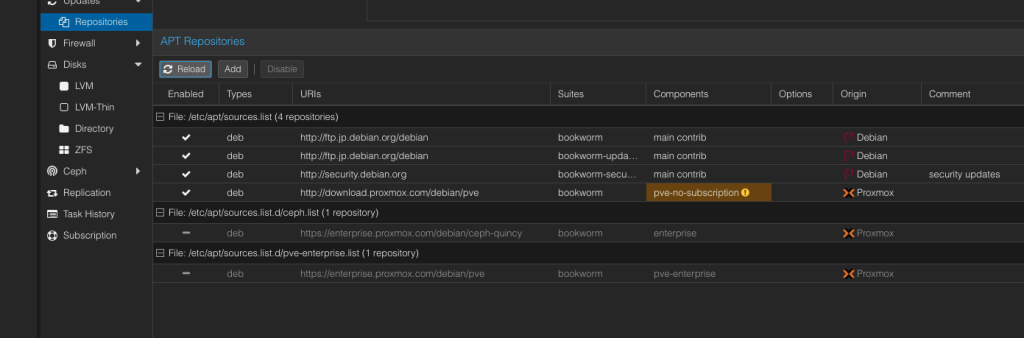

・Proxmox Subscription リポジトリの設定 (必要に応じて)

テスト版やエンタープライズ版リポジトリの利用状況に合わせて、/etc/apt/sources.list や /etc/apt/sources.list.d/pve-enterprise.list を調整します。

今回はテスト用途なので、enterprise版のリポジトリはDisableで無効化し、no-subcription用のレポジトリを追加します。

・パッケージアップデート

apt update

apt dist-upgrade -y

- PVE クラスタに新規ノードを追加

2-2. pvecm add コマンドによるクラスタ参加手順

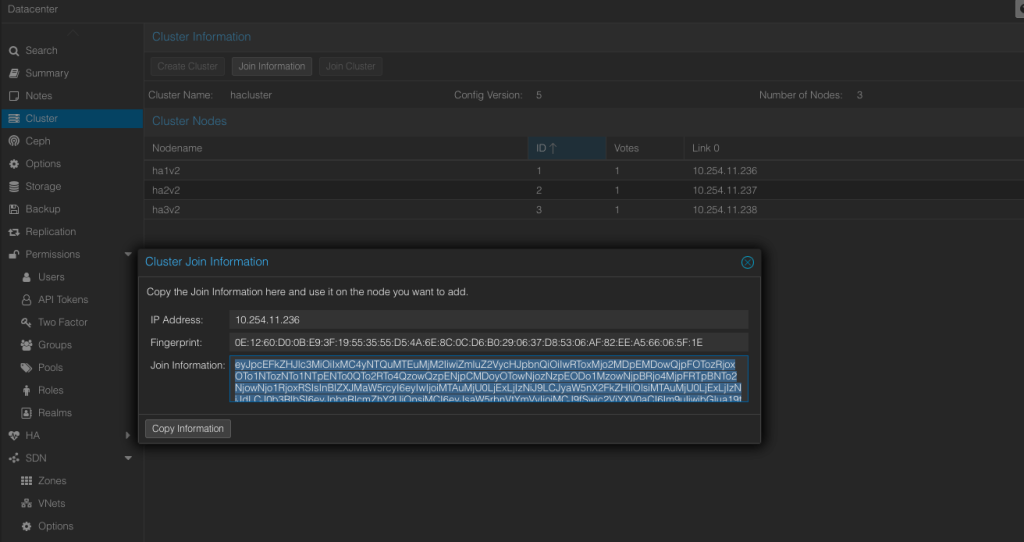

・既存クラスタの情報取得

既存ノード側で、Detacenter→Cluster→Join Informationをクリックし、CopyInformationで必要な情報をコピーします。

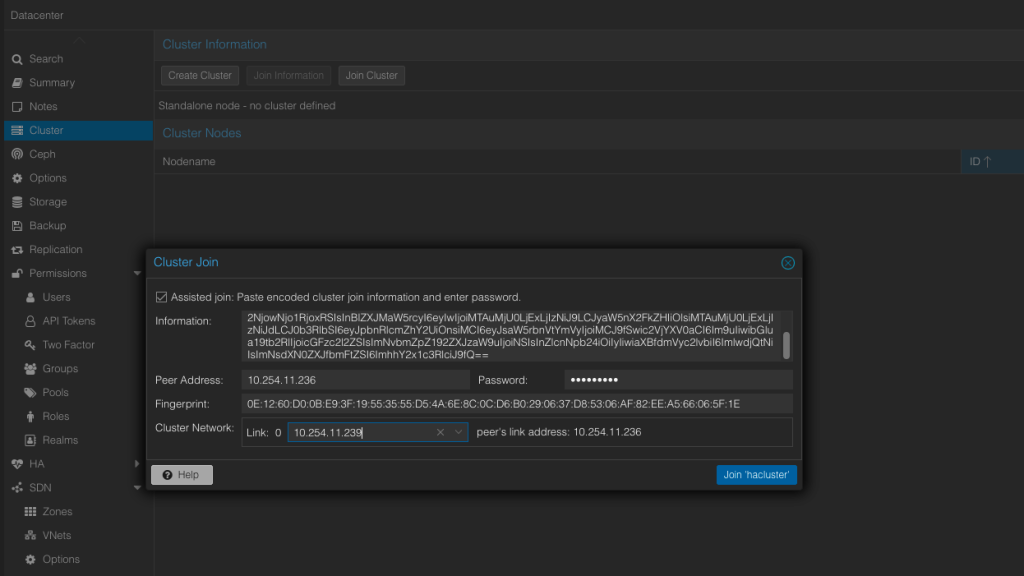

・新規ノードでクラスタに参加

新規ノード側で、Datacenter→Cluster→Join Clusterをクリックし、Informationの欄に上記でコピーしたものをペーストします。

ペーストすると、自動で情報が更新されます。残りのPasswordとClusterNetworkの欄を入力してJoinClusterをクリック。

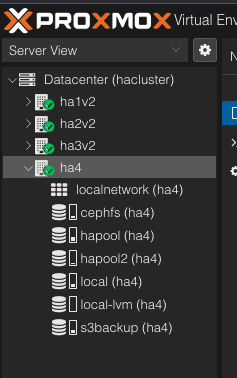

・クラスタ参加確認

既存ノードのWebコンソールを更新し、追加したノードが表示されることを確認。

- Ceph のインストール・設定 (新規ノード側)

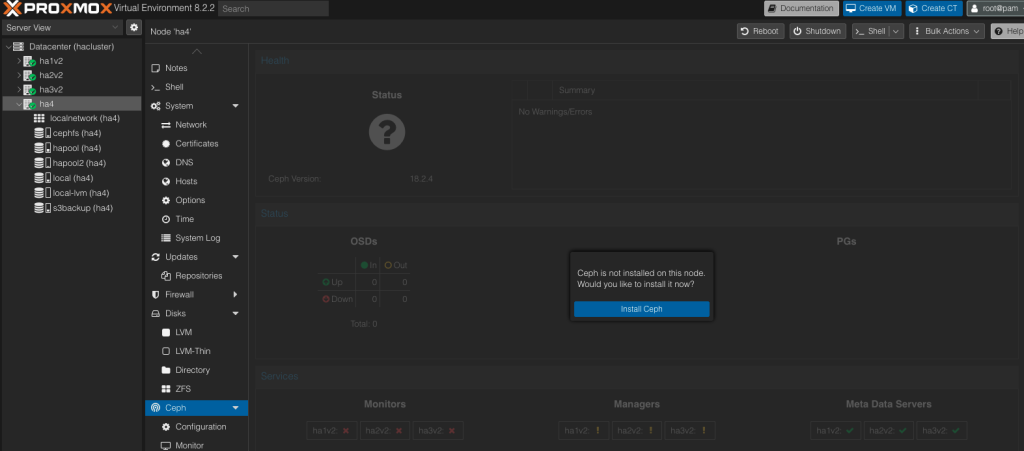

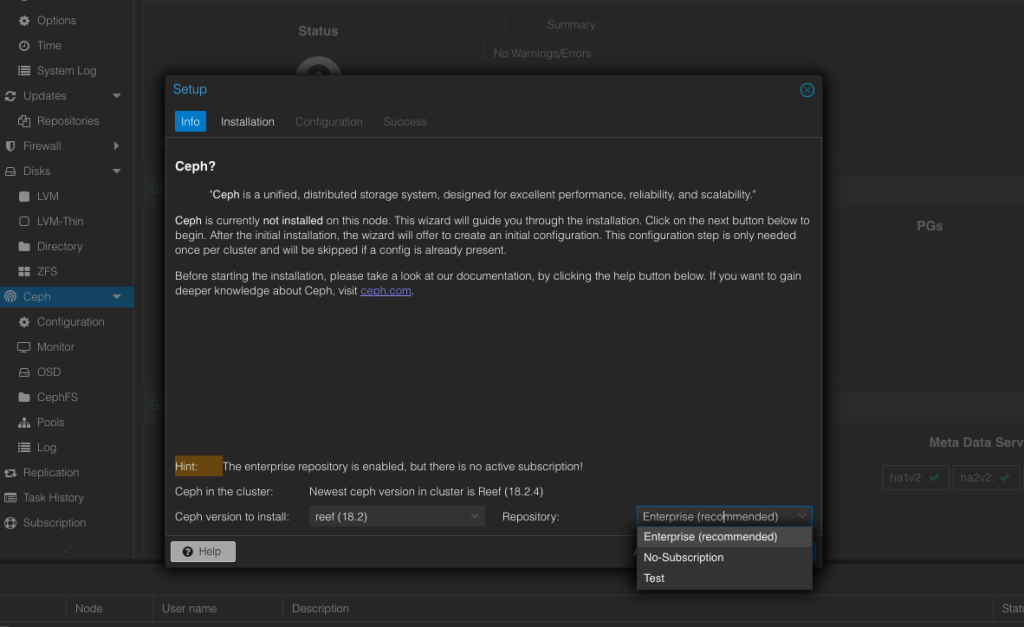

3-1. Ceph パッケージのインストール

既存クラスタで Ceph が利用されている場合、新規ノードにも Ceph 関連パッケージを導入します。

Proxmox VE 8.x の場合、GUI から簡単にインストールできます。

Datacenter を選択

右上の Ceph タブをクリック

Install Ceph ボタンを押す(インストールウィザードに従う)

今回はテスト用途なので、No-Subcriptionを選択します。

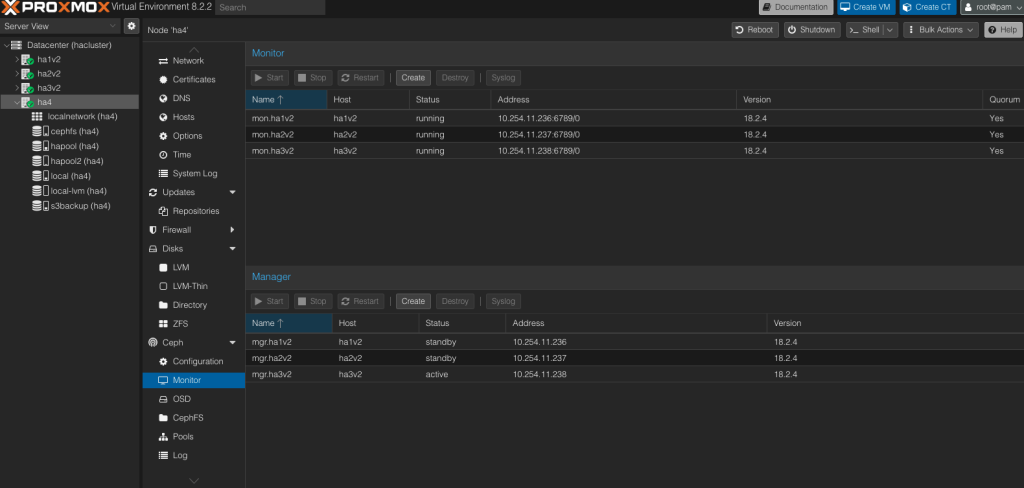

3-2. Ceph クラスタのモニタ設定

新規ノードでも Ceph クラスタのモニタ、メタデータサーバ(MDS)などが連携できるよう、既存 Ceph クラスタのMonitor、Managerに参加させます。

Web UI 上の Ceph→Monitor→Create→新規ノードを選択し、Ceph Monitor を作成します。

同様に、Ceph Managerも作成します。

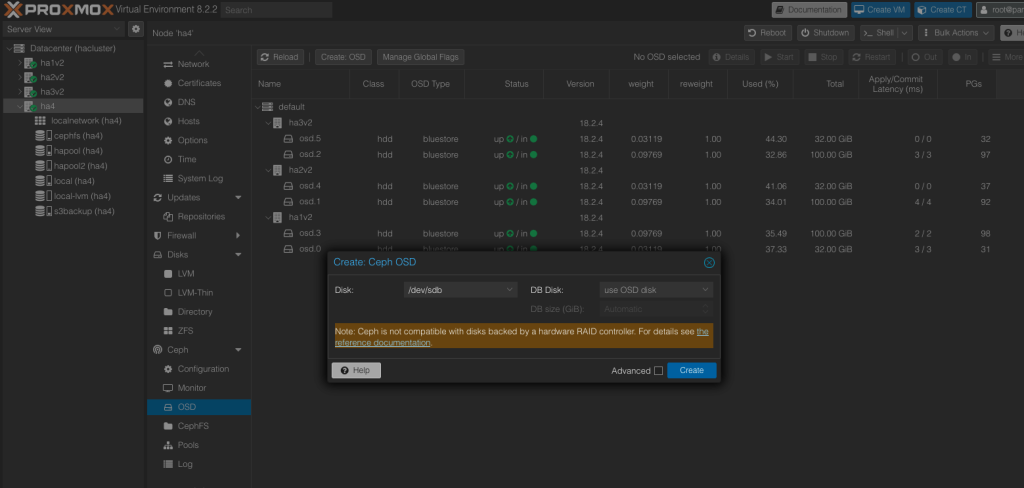

- OSD の追加

4-1. ディスクの準備

Ceph で OSD として利用するディスクを新規ノードに接続しておきます。

/dev/sdb や /dev/sdc など OS インストールディスクとは別に用意することが多いです。

4-2. OSD 作成

Web UI 上で新規ノード→Ceph→OSD にて Create OSD ボタンを押し、対象ディスクを選択して OSD を作成します。

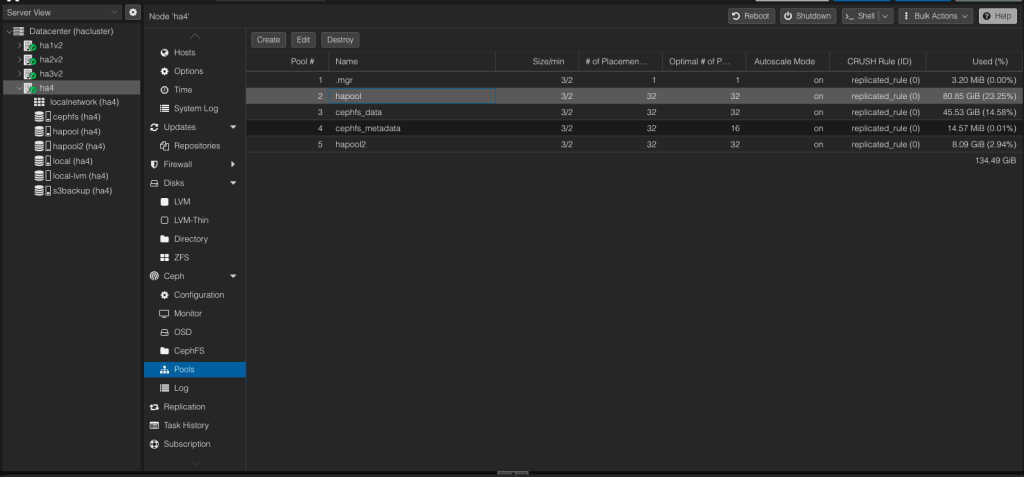

4-3. Ceph Poolへの追加

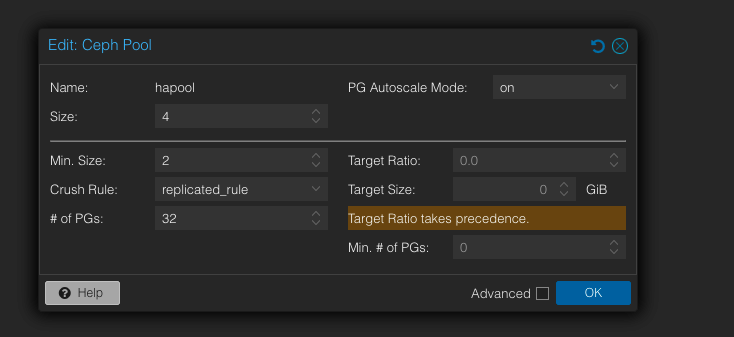

実際に使用したいPoolを選択し、Edit→Sizeを1つ上げてOKをクリック。(Min.Sizeも必要に応じてサイズアップ)

- まとめ

本記事では、Proxmox VE で新規ノードをクラスタに追加する手順から Ceph の OSD 作成までを解説しました。クラスタ規模を拡張したり、障害対策として冗長化を高める際にご活用いただければ幸いです。

コメント